वैसे तो आर्टिफिशियल इंटेलिजेंस को आज के समय में सबसे अच्छे समस्या-समाधान उपकरणों में से एक माना जाता है, लेकिन आपातकालीन स्थिति में इसके नतीजे बहुत भरोसेमंद नहीं।

अध्ययन से यह भी पता चला कि मरीजों के हृदय संबंधी जोखिम का आकलन करने के लिए डॉक्टरों द्वारा इस्तेमाल किए जाने वाले पारंपरिक तरीकों की तुलना में चैटजीपीटी का प्रदर्शन कमजोर था।

कई मामलों और स्थितियों में एआई तकनीक ने कागजी कार्रवाई और कुछ मामलों में मूल्यांकन चरणों में चिकित्सकों के साथ सहयोग करने की उच्च क्षमता का प्रदर्शन किया है। हालाँकि, अब एक नए अध्ययन से पता चलता है कि आपातकालीन स्थिति में यह तकनीक बेहद अनुपयोगी और हानिकारक साबित हो सकती है।

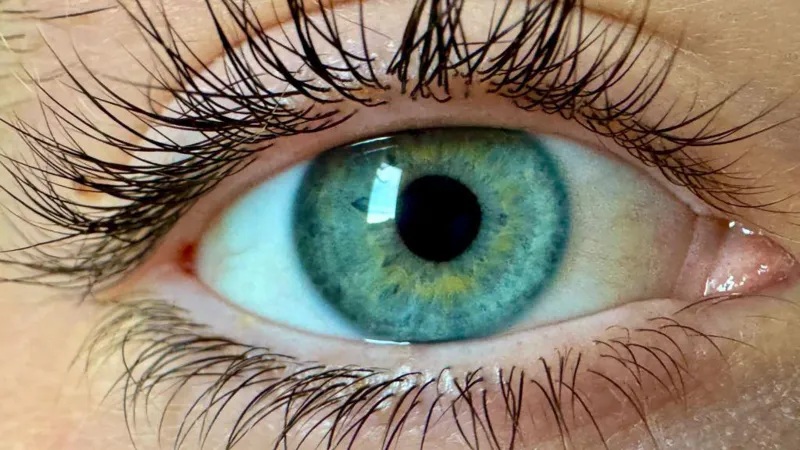

ओपनएआई के चैटजीपीटी कार्यक्रम ने आपातकालीन सेटिंग में सीने में दर्द वाले रोगियों के लिए परस्पर विरोधी परिणाम दिए हैं।

AI’s Inconsistency in Medical Emergencies Raises Concernshttps://t.co/nBhaVOQHnF pic.twitter.com/z99t1ee8Fa

— Cryptopolitan (@CPOfficialtx) May 2, 2024

एक प्रयोग में, एआई ने एक ही मरीज के लिए अलग-अलग परिणाम दिए, जो मरीज के लिए खतरनाक साबित हो सकता है।

वाशिंगटन स्टेट यूनिवर्सिटी के एसोसिएट प्रोफेसर और प्रमुख शोधकर्ता डॉ. थॉमस हेस्टन ने कहा कि चैटजीपीटी लगातार काम नहीं कर रहा है। उसी डेटा को देखते हुए, चैटजीपीटी कभी-कभी एक मरीज के परिणाम को कम जोखिम, दूसरे को मध्यम जोखिम और कभी-कभी उच्च जोखिम के रूप में रेट करता है।

परिणामों में मिलने वाले इन अंतरों को देखकर अब जानकार भी इस विषय में बहुत संतोष नज़र नहीं आ रहे हैं। उनका मानना है कि आपातकालीन स्थिति में ये नतीजे संदेह पैदा करते हैं और ऐसे में उपकरण की विश्वसनीयता संदिग्ध हो जाती है।

डॉ. हेस्टन ने स्वास्थ्य देखभाल सहायता को बढ़ावा देने के लिए एआई की क्षमता की ओर इशारा किया और इसमें निहित कमियों को दूर करने के लिए गहन अध्ययन करने की आवश्यकता पर बल दिया।

उनके मुताबिक़, एआई एक आवश्यक उपकरण हो सकता है, लेकिन हम जितना समझते हैं उससे कहीं अधिक तेजी से आगे बढ़ रहे हैं। इसलिए, हमें बहुत अधिक शोध करना चाहिए, विशेष रूप से आम तौर पर सामने आने वाली नैदानिक स्थितियों में।